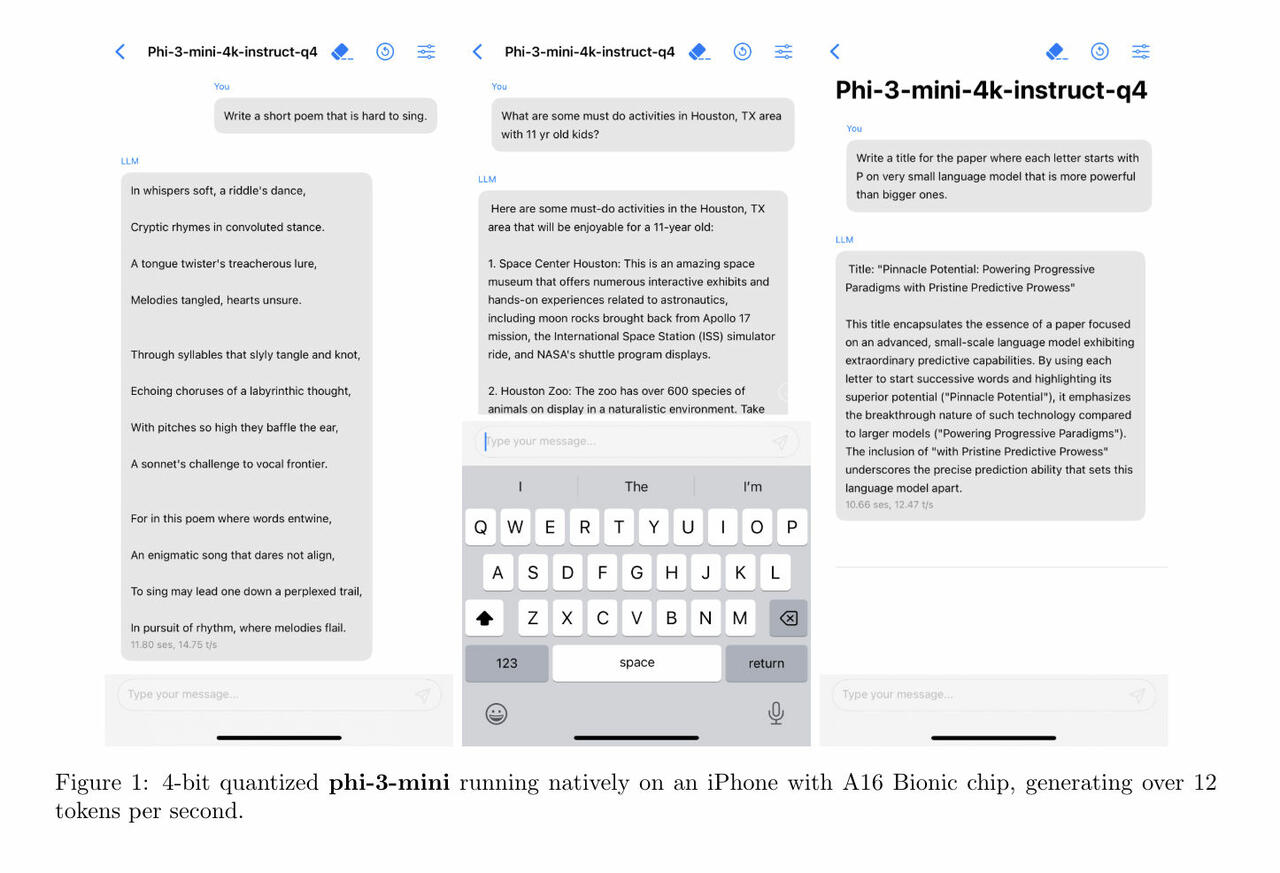

Microsoft Phi-3 Mini KI-Modell als LLM für iPhone und Smartphones (Bild © Microsoft )

Microsoft Phi-3 Mini KI-Modell als LLM für iPhone und Smartphones (Bild © Microsoft )

Phi-3 Mini ist der Vorläufer von zwei weiteren Modellen der Serie - Phi-3 Small und Phi-3 Medium - mit 7 Milliarden bzw. 14 Milliarden Parametern. Parameter definieren in diesem Zusammenhang die Komplexität und Tiefe der Aufgaben, die die Modelle bewältigen können. Diese Initiative folgt auf die Veröffentlichung des Phi-2 im Dezember, der laut Microsoft mit deutlich größeren Modellen mithalten kann. Phi-3 Mini übertrifft Phi-2 nicht nur in der Leistung, sondern liefert auch Antworten, die mit Modellen vergleichbar sind, die zehnmal so groß sind.

Die Entwicklung von Phi-3 Mini und seinen Nachfolgern unterstreicht Microsofts strategische Ausrichtung auf kleinere, kostengünstigere KI-Modelle, die für persönliche Geräte wie Smartphones und Laptops geeignet sind. Dieser Schritt steht im Einklang mit dem wachsenden Branchentrend zu leichtgewichtigen KI-Lösungen, die geringere Betriebskosten und eine bessere Anwendbarkeit in der Unterhaltungselektronik bieten. Zusätzlich zu den Phi-Modellen hat Microsoft spezielle Modelle wie Orca-Math entwickelt, das sich auf die Lösung mathematischer Probleme konzentriert. Durch diese Diversifizierung des Angebots an KI-Modellen kann Microsoft auf verschiedene Branchenbedürfnisse eingehen, von der Unterstützung im Bildungsbereich bis hin zu professioneller Hilfe bei der Programmierung.

Konkurrenten wie Google und Anthropic entwickeln ebenfalls kleinere KI-Modelle, die auf Anwendungen von einfachen Chatbots bis hin zu komplexen Aufgaben der Dokumentenzusammenfassung abzielen. Die Modelle Gemma 2B und 7B von Google eignen sich beispielsweise für sprachbezogene Aufgaben, während das Modell Claude 3 Haiku von Anthropic detaillierte Forschungsarbeiten effizient zusammenfassen kann.

Microsofts Phi-3 bietet zwar erhebliche Vorteile bei Codierungs- und Argumentationsaufgaben, erreicht aber nicht die Breite des Wissens, auf das Modelle zugreifen können, die auf umfangreicheren Datensätzen wie GPT-4 trainiert wurden. Für viele Unternehmen erweisen sich jedoch die Effizienz und Kosteneffizienz kleinerer Modelle wie Phi-3 als wertvoller, insbesondere wenn sie mit begrenzten internen Datensätzen arbeiten. Diese Ausgewogenheit macht Phi-3 und ähnliche Modelle für bestimmte Anwendungen attraktiv und unterstreicht den praktischen Nutzen von skalierten KI-Technologien in der Branche.