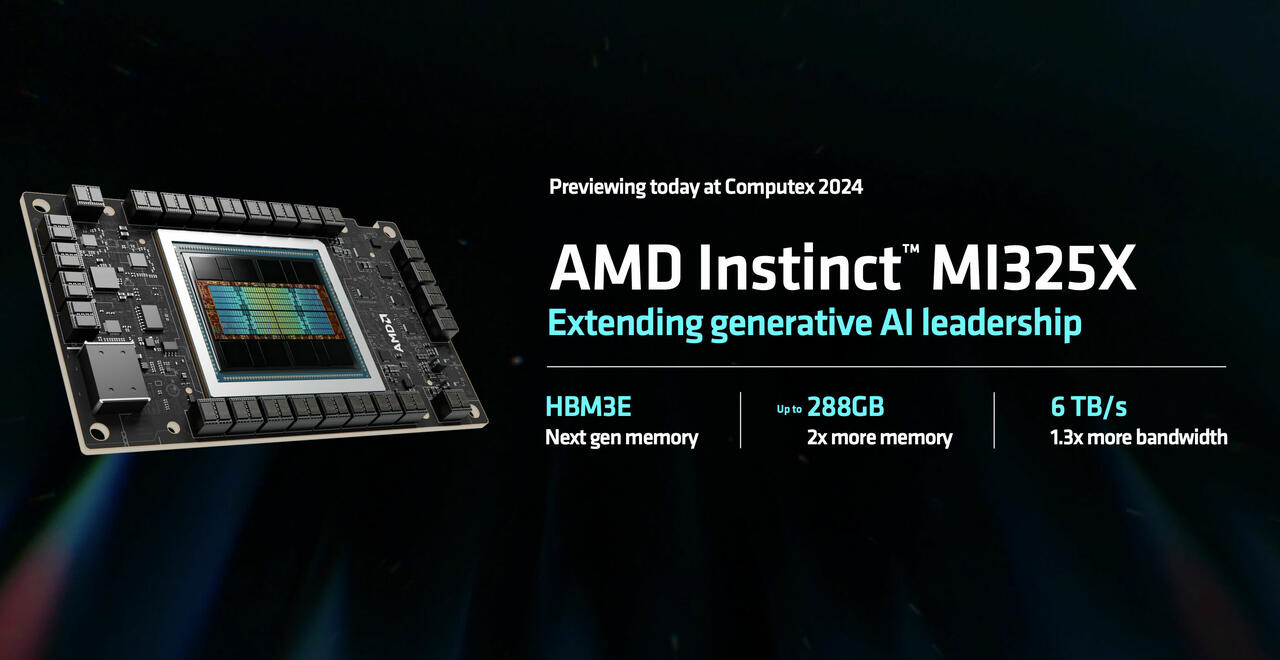

AMD Instinct MI325X (Bild © AMD)

AMD Instinct MI325X (Bild © AMD)

Benchmark-Details und Aufbau

Tensorwave führte umfassende Tests durch, bei denen der AMD Instinct MI300X und der NVIDIA H100 Beschleuniger mit dem Mixtral 8x7B Modell verglichen wurden. Die Tests umfassten sowohl Online- als auch Offline-Szenarien, um reale KI-Anwendungen zu simulieren.

AMD MI300X Spezifikationen

- Hardware: Der Tensorwave-Knoten ist mit 8 MI300X-Beschleunigern, 2 AMD EPYC CPU-Prozessoren (192 Kerne) und 2,3 TB DDR5-RAM ausgestattet.

- Beschleuniger-Specs: 192 GB VRAM, 5,3 TB/s Bandbreite, ~1300 TFLOPS für FP16.

- Treiber: ROCm 6.1.2.

- Inferenz-Stack: MK1's inference engine (Flywheel) v0.9.2, ROCm optimized fork of vLLM (rocm/vllm) v0.4.0.

- Konfiguration: Tensor-Parallelität auf 1 gesetzt.

NVIDIA H100 Spezifikationen:

- Hardware: Baremetal-Knoten mit 8 H100 SXM5 Beschleunigern mit NVLink, 160 CPU-Kernen und 1,2 TB DDR5 RAM.

- Beschleuniger-Spezifikationen: 80 GB VRAM, 3,35 TB/s Bandbreite, ~986 TFLOPS für FP16.

- Treiber: CUDA 12.2.

- Inferenz-Stack: vLLM v4.3.

- Konfiguration: Tensor-Parallelität auf 2 eingestellt.

Leistungsergebnisse

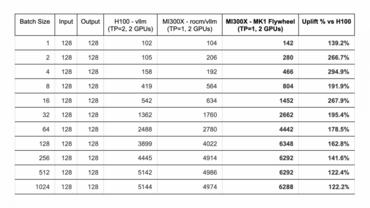

Offline-Leistung:

Der AMD Instinct MI300X übertraf den NVIDIA H100 bei allen Stapelgrößen und zeigte bei LLM-Inferenzaufgaben einen Leistungsanstieg von 22% bis 194% (fast 3x). Diese Leistung war bei allen Stapelgrößen von 1 bis 1.024 gleich.

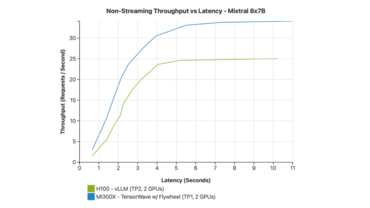

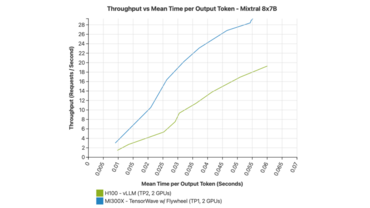

Online-Leistung:

Die Online-Tests von Tensorwave simulierten realistische Chat-Anwendungsszenarien und maßen den Durchsatz, die durchschnittliche Latenzzeit und die Zeit pro Output-Token (TPOT). Der AMD MI300X erreichte:

- 33% mehr Anfragen pro Sekunde im Vergleich zu zwei NVIDIA H100 GPUs.

- Eine durchschnittliche Latenzzeit von 5 Sekunden.

- Höherer Durchsatz und schnellere Textgenerierung bei hohem Verkehrsaufkommen.

Technische Einblicke und Optimierungen

Die überlegene Leistung des MI300X ist zum Teil auf seine fortschrittliche Architektur und die Optimierung durch AMDs ROCm AI Stack zurückzuführen. Die Tests haben Folgendes gezeigt:

- Erhöhter VRAM: Der 192 GB große VRAM des MI300X im Vergleich zum 80 GB großen VRAM des H100 ermöglicht eine bessere Verarbeitung großer Modelle.

- FP16 Rechenleistung: Beide Systeme wurden für FP16 konfiguriert, wobei FP8-Rechenpfade für zukünftige Evaluierungen vorgesehen sind.

- Treiber und Software-Stacks: AMDs ROCm 6.1.2 und NVIDIAs älterer CUDA 12.2 Stack wurden verwendet, wobei die Leistung von NVIDIA durch neuere Software-Updates gesteigert werden könnte.

Auswirkungen auf den Markt

Der CEO von Tensorwave hob die beeindruckende Leistung und den wettbewerbsfähigen Preis des MI300X als entscheidende Vorteile gegenüber dem NVIDIA H100 hervor. Außerdem macht die Verfügbarkeit des MI300X ihn zu einer praktikablen Option für Unternehmen, die ihre KI-Fähigkeiten schnell ausbauen wollen. Der MI300X hat sich aufgrund seines höheren Durchsatzes und seiner geringeren Latenz in realen Anwendungen bereits als bevorzugte Wahl positioniert.

Fazit

Der AMD MI300X Beschleuniger setzt offensichtlich neue Maßstäbe in der KI-Leistung und übertrifft den H100 von NVIDIA deutlich. Mit seinen fortschrittlichen Fähigkeiten, dem wettbewerbsfähigen Preis und der besseren Verfügbarkeit ist der MI300X auf dem besten Weg, ein dominierender Akteur auf dem KI-Hardwaremarkt zu werden. Unternehmen, die ihre KI-Infrastruktur ausbauen wollen, sollten den MI300X aufgrund seiner überragenden Leistung und seines Wertes in Betracht ziehen.