LM Studio Windows (Bild © PCMasters)

LM Studio Windows (Bild © PCMasters)

Größere Modelle übersteigen jedoch oft die Speicherkapazität von Consumer-GPUs, so dass innovative Lösungen erforderlich sind, um diese leistungsstarken Tools auf alltägliche Systeme zu bringen.

Lokale KI mit GPU-Offloading

GPU Offloading ist eine Technik, die es auch Nutzern mit leistungsschwächeren GPUs ermöglicht, die Leistung von LLMs zu nutzen, indem die Verarbeitung zwischen CPU und GPU aufgeteilt wird. Diese Methode stellt sicher, dass die Nutzer auch dann von der GPU-Beschleunigung profitieren können, wenn ein LLM den verfügbaren Videospeicher der GPU übersteigt.

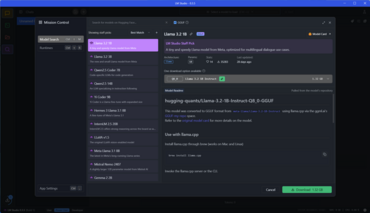

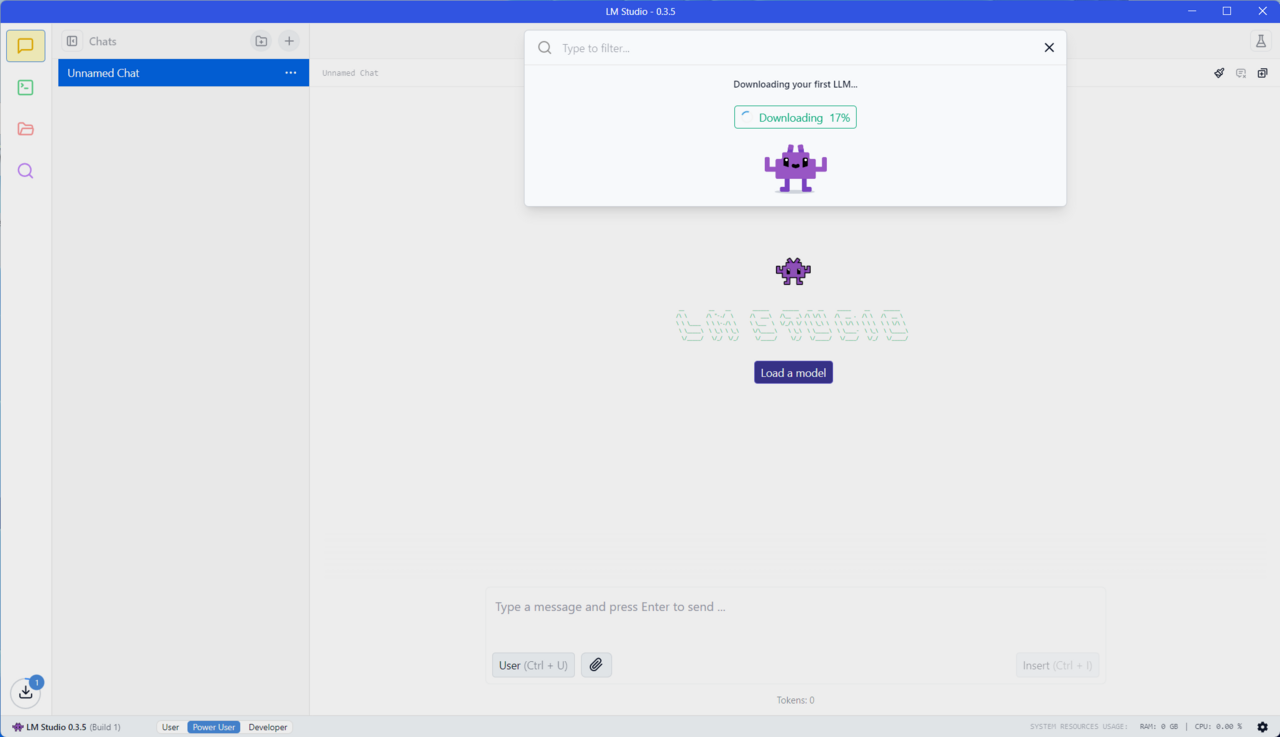

LM Studio macht sich diesen Ansatz zunutze und bietet eine intuitive Schnittstelle zum Herunterladen und lokalen Ausführen von LLMs. LM Studio basiert auf llama.cpp und ermöglicht es den Nutzern, genau einzustellen, wie viel von einem Modell auf den Grafikprozessor übertragen werden soll, damit sie die Leistung präzise steuern können. Das User Interface is dabei sehr schlicht und intuitiv gehalten.

Mehr Leistung ohne maximalen VRAM

Ein großes Modell wie Gemma-2-27B mit 27 Milliarden Parametern benötigt zum Beispiel 19 GB VRAM für die volle GPU-Beschleunigung. Mit dem GPU-Offloading können Nutzer mit leistungsschwächeren Systemen dennoch einen erheblichen Leistungsschub erzielen, indem sie einen Teil des Modells auf dem Grafikprozessor und den Rest auf der CPU ausführen.

Tests haben gezeigt, dass das Offloading den Durchsatz dramatisch verbessern kann: von nur einigen Token pro Sekunde auf der CPU allein auf weitaus höhere Geschwindigkeiten, wenn ein größerer Teil des Modells auf der GPU verarbeitet wird. Bei unserem Testsystem mit Rtyzen 9 9750X CPU, 32 GB RAM und der GeForce RTX 4090, konnten wir LLAMA 3.2 3B laufen lassen und erreichten dabei ca. 77 Token pro Sekunde, was schon sehr schnell und für den täglichen Gebrauch mehr als ausreichend ist.

Optimierung der LLM-Leistung

Mit dem Schieberegler für das GPU-Offloading von LM Studio kann je nach Systemkonfiguration das richtige Gleichgewicht zwischen Leistung und Speichernutzung finden. Egal, ob du eine High-End GeFroce RTX 4090 oder eine bescheidenere GPU verwendest, LM Studio stellt sicher, dass du das volle Potenzial von LLMs auf deinen lokalen Systemen ausschöpfen kannst.

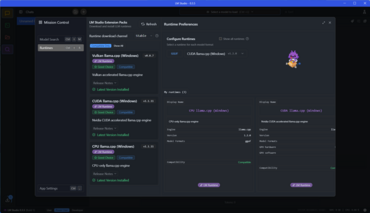

In den Einstellungen von LM Studio gibt es neben CPU llama.cpp für CPUs, CUDA llama.cpp für NVIDIA-Grafikkarten und Vulkan llama.cpp für AMD-Grafikkarten gesetzt werden. Es lassen sich auch andere Modelle in den Eintsellungen durchsuchen und installieren. Es ist ein optimales Front-End für erfahrene und nicht so erfahrene Nutzer.