Deepseek lokal installieren (Bild © Deepseek)

Deepseek lokal installieren (Bild © Deepseek)

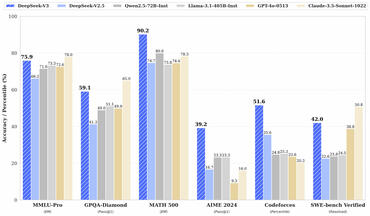

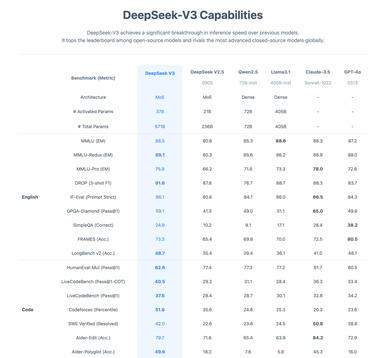

Schnelles LLM-Wachstum unter Ressourcenbeschränkungen

Aufgrund der US-Exportbestimmungen, die den Zugang zu fortschrittlichen KI-Chips einschränken, fragen sich Brancheninsider, wie Deepseek es geschafft hat, so schnell anspruchsvolle Modelle zu trainieren. Einige vermuten, dass das Unternehmen die Methode der Modelldestillation anwendet, bei der ein kleineres Modell mit den Erkenntnissen aus einem größeren Modell trainiert wird. Es wird spekuliert, dass Deepseek einen Weg gefunden haben könnte, die Halbleiterbeschränkungen zu umgehen, indem es sich leistungsstarke Grafikprozessoren wie den H100 für das Training gesichert hat - allerdings gibt es dafür keine Bestätigung.

Größere Sorgen um die KI-Führerschaft der USA

Investoren und KI-Experten weisen darauf hin, dass die offensichtliche Fähigkeit von Deepseek, große Leistungen zu relativ geringen Kosten zu erzielen, eine ernsthafte Herausforderung für die Vormachtstellung der USA im Bereich KI darstellt. Es heißt, dass Mitarbeiter von Meta die Methoden von Deepseek überprüfen und befürchten, dass die generativen KI-Bemühungen ihres Unternehmens vergleichsweise weniger effizient sind. Ein durchgesickerter Kommentar eines Meta-Mitarbeiters zeigt die Frustration über das interne Gerangel, die Erfolge von Deepseek zu analysieren und zu wiederholen.

Der CEO von Microsoft bezeichnete das neue Open-Source-Modell von Deepseek als „unglaublich beeindruckend“ und lobte seine Effizienz beim Training und bei den Schlussfolgerungen. Er bezeichnete es als Beweis für die wachsende Präsenz Chinas im Bereich der fortgeschrittenen KI und forderte die Branche auf, den Fortschritten des Start-ups große Aufmerksamkeit zu schenken.

Deepseek-R1 lokal nutzbar

Mit der Vorstellung von Deepseek-R1 so kurz nach Deepseek-V3 signalisiert das Unternehmen sein Engagement für schnelle Iterationen und kosteneffiziente Skalierung. Das Modell gibt es sogar auf HuggingFace zum Downloaden und es wiegt je nach Variante 300 bis 700 GB, wobei die Konkurrenzmodelle eher bis 40 GB gehen. Es gibt auch destillierte Varianten, die kleiner sind. Dennoch ist das eine starke Offensve aus China.