AMD A10-7850K-Prozessor (Bild © PugetSystems)

AMD A10-7850K-Prozessor (Bild © PugetSystems)

Die technischen Daten der neuen Desktop-APU-Speerspitze sind bereits seit mehreren Wochen bekannt, jetzt sind endlich auch erste Benchmarks des AMD A10-7850K-Prozessors an die Öffentlichkeit gelangt. Wie bereits zu vermuten war, ist das neue Modelle schneller als sein Vorgänger, zumindest bei der GPU-Leistung. In puncto Prozessor-Geschwindigkeit ist der A10-6800K, aufgrund seines höheren Taktes, aber minimal flotter unterwegs. Ebenfalls mit im Vergleich ist auch ein Intel Core i5-4440, dessen vier Kerne mit je 3,1 GHz laufen.

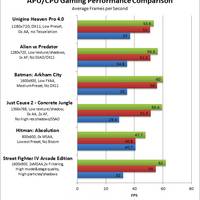

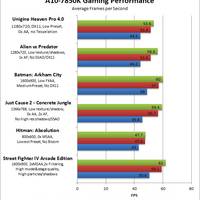

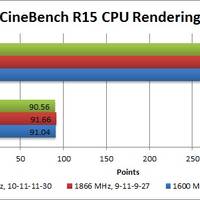

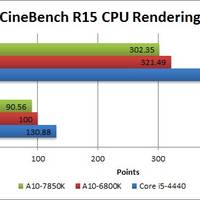

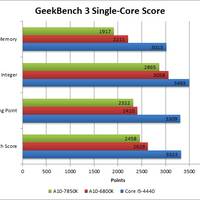

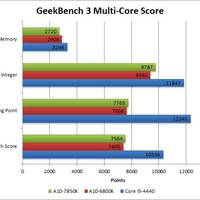

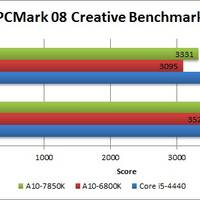

Die Webseite PugetSystems hat die neue APU unter anderem in verschiedenen Spielen (Alien vs. Predator, Batman: Arkham City, Just Cause 2, Hitman: Absolution und Street Fighter IV Arcade Edition) sowie CPU- (GeekBench 3) und System-Benchmarks (PCMark 8 und CineBench R15) getestet, sodass Nutzer einen guten Gesamteindruck darüber bekommen können, was der Prozessor leisten kann. Das Ergebnis ist jedoch nicht so eindeutig, wie es sich AMD vielleicht gewünscht hätte. Wird die integrierte Radeon R7-GPU gefordert, kann sich der A10-7850K von den beiden anderen Testkandiaten absetzen; den A10-6800K hält man mit minimal 2,6 bis maximal 7,9 FPS auf Abstand, die Intel HD4600 sieht hingegen kein Land. Das Bild ändert sich allerdings schlagartig, sobald der CPU-Part in Anspruch genommen wird; dann kann die ältere AMD-Generation den "Kaveri"-Neuling in die Schranken weisen. Der Intel-Prozessor entfaltet hier sein volles Potential und lässt seine beiden Kontrahenten ganz schön alt aussehen.

Hier die Benchmarks in ganzer Pracht: