AMD Instinct MI300X (Bild © AMD)

AMD Instinct MI300X (Bild © AMD)

MLPerf 5.0: AMD Instinct MI325X und MI300X GPUs zeigen starke Ergebnisse

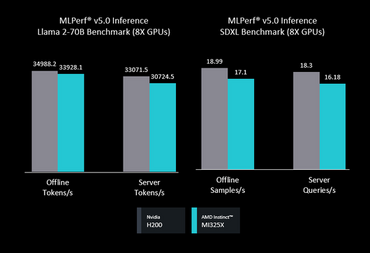

Die kürzlich vorgestellten Instinct MI325X Grafikprozessoren zeigten sowohl bei Llama 2 70B als auch bei Stable Diffusion XL (SDXL) eine konkurrenzfähige Leistung gegenüber den H200 Grafikprozessoren von NVIDIA. Darüber hinaus erreichte AMDs Multi-Node-Beitrag in Zusammenarbeit mit MangoBoost mit vier MI300X-GPUs die höchste jemals gemessene Offline-Inferenzleistung im Llama 2 70B-Benchmark.

Mehrere Industriepartner, darunter Supermicro, ASUS, Gigabyte und MangoBoost, haben zum ersten Mal unabhängige Ergebnisse mit AMD Instinct GPUs vorgelegt, was das wachsende Vertrauen des Marktes in AMDs KI-Lösungen unterstreicht. Die von den Partnern vorgelegten Ergebnisse stimmten eng mit den internen Benchmarks von AMD überein, was die Konsistenz und Zuverlässigkeit von AMDs neuester GPU-Generation in verschiedenen Einsatzszenarien unterstreicht.

Fortschrittliche Software und Ecosystem-Tools sorgen für Leistungssteigerungen

AMD sieht eine entscheidende Rolle beim Erfolg der Benchmarks die kontinuierliche Innovation der ROCm-Softwareplattform. Die ROCm-Updates haben das Kernel-Scheduling, die GEMM-Operationen und die Effizienz der Inferenzen insgesamt optimiert. Nebenbei ermöglichte AMDs Quark-Tool die FP16-zu-FP8-Quantisierung, was die Inferenzleistung bei komplexen Workloads erheblich verbesserte.

Die neu eingeführte AI Tensor Engine for ROCm (AITER) von AMD beschleunigt kritische AI-Modellkomponenten, indem sie die Ausführung von Decodern bis zu 17-mal schneller macht und den Durchsatz bei LLM-Inferenzaufgaben verdoppelt. In Verbindung mit der Open Performance and Efficiency Architecture (OPEA) erhalten Nutzer einen umfassenden Einblick in die Rechen-, Speicher- und Energienutzung und können so die Leistung von KI-Implementierungen optimieren.

Der verbesserte AMD GPU Operator vereinfacht den Kubernetes-nativen Einsatz von Instinct-GPUs weiter, reduziert die betriebliche Komplexität, automatisiert die Verwaltung mehrerer GPU-Instanzen und verbessert die Skalierbarkeit in Produktionsumgebungen.

Herausragende Leistung bei führenden Open-Source-KI-Modellen

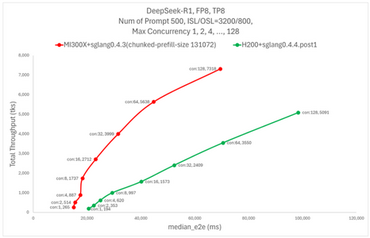

Neben standardisierten Benchmarks liefert die Instinct GPUs von AMD auch in realen Open-Source-Modellszenarien gute Werte. Schnelle ROCm-gesteuerte Optimierungen haben die Inferenzgeschwindigkeit für das DeepSeek-R1-Modell innerhalb von nur zwei Wochen um das Vierfache erhöht und bieten damit eine konkurrenzfähige Leistung im Vergleich zu NVIDIAs H200.

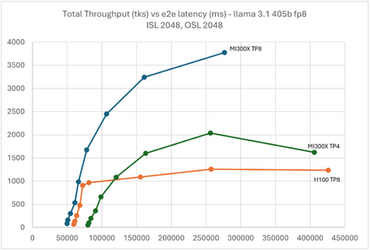

Auch die AMD Instinct MI300X GPUs zeigten bei Llama 3.1 405B eine deutliche Leistungssteigerung und übertrafen NVIDIAs H100 GPU bei speichergebundenen Arbeitslasten. Dank der überragenden Speicherbandbreite werden weniger MI300X-Knoten benötigt, was die Infrastrukturkosten senkt und die Leistung für große generative KI-Einsätze optimiert.