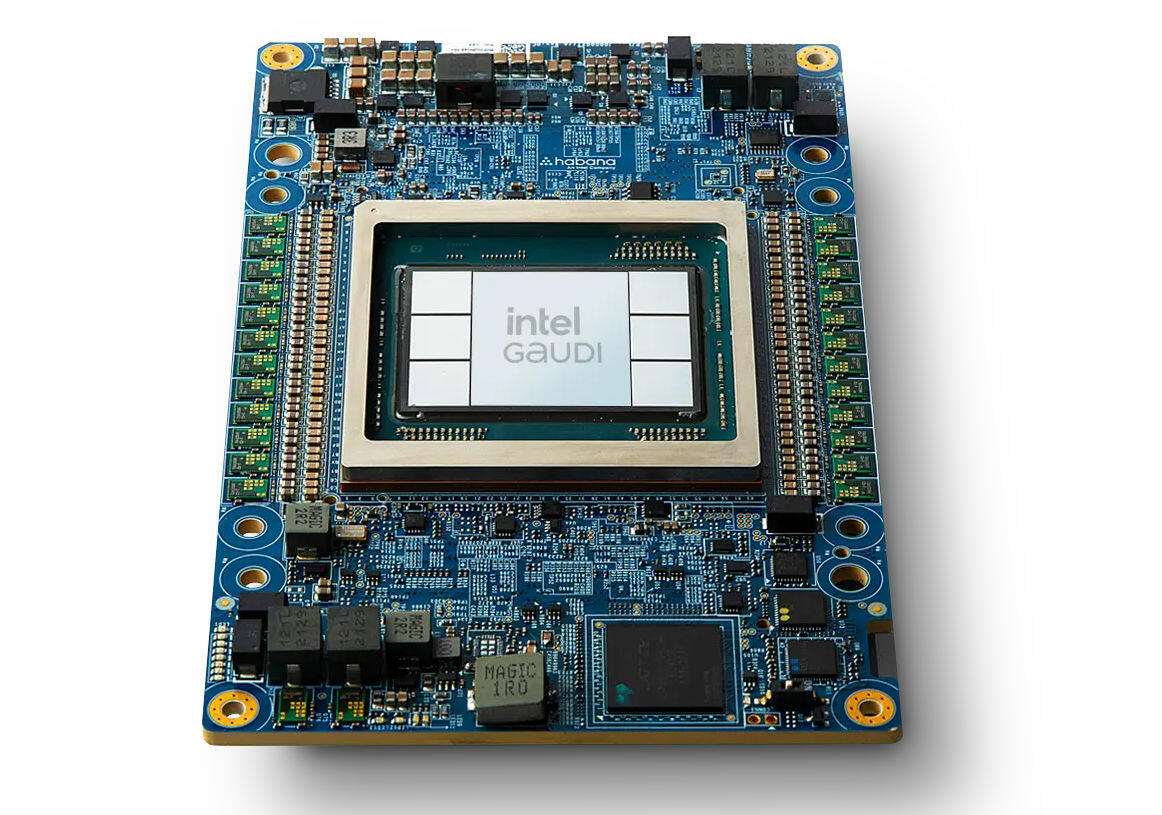

Intel Gaudi 2 (Bild © Intel)

Intel Gaudi 2 (Bild © Intel)

Generativen KI Benchmark mit Stable Diffusion 3

In Tests mit 2 Nodes mit je 16 Beschleunigern und einer Stapelgröße von 16 pro Beschleuniger konnte die Gaudi2-Konfiguration 927 Bilder pro Sekunde erzeugen. Diese Leistung übertraf die 595 Bilder pro Sekunde des H100 und die 381 Bilder pro Sekunde des A100 unter gleichen Bedingungen deutlich. Bei einer Erweiterung auf 32 Knoten mit 256 Beschleunigern stieg die Leistung des Gaudi2 auf 12.654 Bilder pro Sekunde oder 49,4 Bilder pro Sekunde pro Gerät und stellte damit die 3.992 Bilder pro Sekunde oder 15,6 Bilder pro Sekunde pro Gerät des A100 "Ampere"-Arrays in den Schatten.

Stability AI hat jedoch eine wichtige Beobachtung gemacht: Bei der Verwendung der Basisversion von PyTorch waren die A100-Chips mit der TensorRT-Optimierung 40 % schneller bei der Bilderzeugung als Gaudi2. In dem Blogbeitrag heißt es: "Bei Inferenztests mit dem Stable Diffusion 3 8B Parametermodell bieten die Gaudi2-Chips eine ähnliche Inferenzgeschwindigkeit wie die Nvidia A100-Chips bei Verwendung von Basis-PyTorch. Mit der TensorRT-Optimierung erzeugen die A100-Chips jedoch 40 % schneller Bilder als Gaudi2." Sie fügten hinzu, dass sie optimistisch sind, dass mit weiteren Verbesserungen die Leistung von Gaudi2 die des A100 übertreffen könnte. Besonders hervorgehoben wird die Fähigkeit von Gaudi2, ein 1024x1024 Bild in 30 Schritten in 3,2 Sekunden zu erzeugen, schneller als die 3,6 Sekunden des A100 mit PyTorch und 2,7 Sekunden mit TensorRT-Optimierung.

Der deutliche Leistungsvorsprung von Intels Gaudi2 wird auf sein spezielles Design für die Beschleunigung von generativer KI und Large Language Models (LLMs) zurückgeführt, zusammen mit seinem überlegenen Interconnect und dem Vorteil eines größeren Speichers von 96 GB. Stability AI ist sehr daran interessiert, Gaudi2 in seine Stability Cloud zu integrieren, was darauf hindeutet, dass in naher Zukunft noch effizientere und leistungsfähigere KI-gesteuerte Bilderzeugungsfunktionen möglich sein werden.