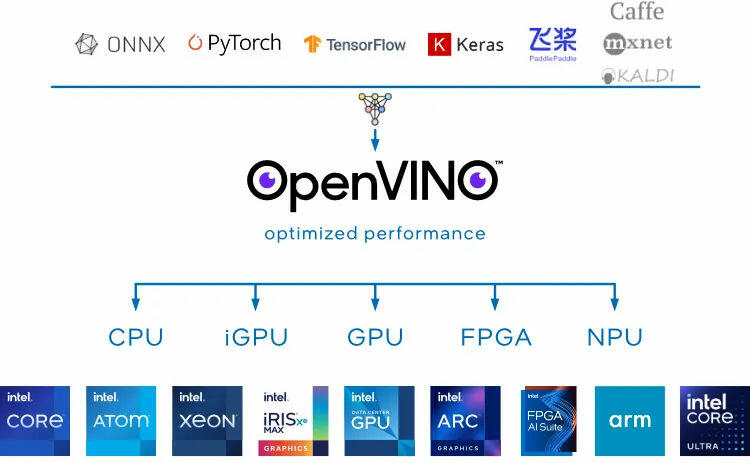

OpenVINO 2024.2 (Bild © Intel)

OpenVINO 2024.2 (Bild © Intel)

Optimierungen für Llama 3 und darüber hinaus

OpenVINO 2024.2 verbessert die Unterstützung für das Large Language Model (LLM) Llama 3 von Meta und sorgt so für eine bessere Leistung und Speichereffizienz bei CPUs, integrierten GPUs und diskreten GPUs. Diese Verbesserungen sind entscheidend für Entwickler, die die Fähigkeiten ihrer Hardware beim Einsatz fortschrittlicher KI-Modelle maximieren wollen.

Die neue Version bietet außerdem Unterstützung für Phi-3-mini, eine Familie von KI-Modellen, die kleine Sprachmodelle für eine schnellere und genauere Textverarbeitung nutzen. Außerdem gibt es eine breitere Unterstützung für große Sprachmodelle (LLMs) und verbesserte Modellkomprimierungstechniken, einschließlich der Hinzufügung der GPTQ-Methode für die 4-Bit-Gewichtskomprimierung, die die Inferenz-Effizienz erhöht.

Leistungsverbesserungen

Signifikante Verbesserungen bei der Second-Token-Latenz und dem Speicherbedarf für FP16-gewichtete LLMs wurden erzielt, insbesondere für AVX2 auf Intel Core Prozessoren und AVX-512 auf Intel Xeon Prozessoren. Diese Verbesserungen sind besonders für Anwendungen mit kleinen Losgrößen von Vorteil.

OpenVINO 2024.2 führt die Python Custom Operation ein, die es Entwicklern ermöglicht, benutzerdefinierte Operationen einfacher in Python zu programmieren. Dies ergänzt die bestehende Unterstützung für benutzerdefinierte C++-Operationen und ermöglicht eine größere Flexibilität bei der Modellanpassung.

Die Version enthält auch eine erweiterte Notebook-Abdeckung, mit neuen Ergänzungen wie DynamiCrafter, YOLOv10 und einem Chatbot-Notebook mit Phi-3. Diese Ressourcen bieten Entwicklern praktische Beispiele, um die Möglichkeiten des Toolkits besser nutzen zu können.

Model Serving und API-Verbesserungen

Intel hat seinen OpenVINO Model Server (OVMS) verbessert und Unterstützung für OpenAI-kompatible APIs und Funktionen wie Continuous Batching und PagedAttention hinzugefügt. Diese Verbesserungen erhöhen den Durchsatz beim parallelen Inferencing erheblich, insbesondere auf Intel Xeon Prozessoren.

Die Integration von TorchServe über das torch.compile OpenVINO-Backend rationalisiert die Modellbereitstellung, -bereitstellung und -wartung. Außerdem bietet die neue Generate API eine vereinfachte Schnittstelle für die Texterzeugung, die es einfacher macht, große Sprachmodelle mit minimalem Code zu implementieren.

Unterstützung für neue Prozessoren

OpenVINO 2024.2 erweitert seine Kompatibilität mit der Intel Atom Processor X Series und bietet eine Vorschau auf den Intel Xeon 6 Prozessor, so dass das Toolkit auf einer breiteren Palette von Hardwareplattformen eingesetzt werden kann.

Die Veröffentlichung von OpenVINO 2024.2 ist ein bedeutender Schritt nach vorn bei der Optimierung und dem Einsatz von KI-Modellen. Mit verbesserter Leistung, breiterer Modellunterstützung und neuen Funktionen bietet Intels neuestes Toolkit leistungsstarke Werkzeuge für Entwickler, die fortschrittliche KI-Funktionen in verschiedenen Hardwareumgebungen nutzen wollen.