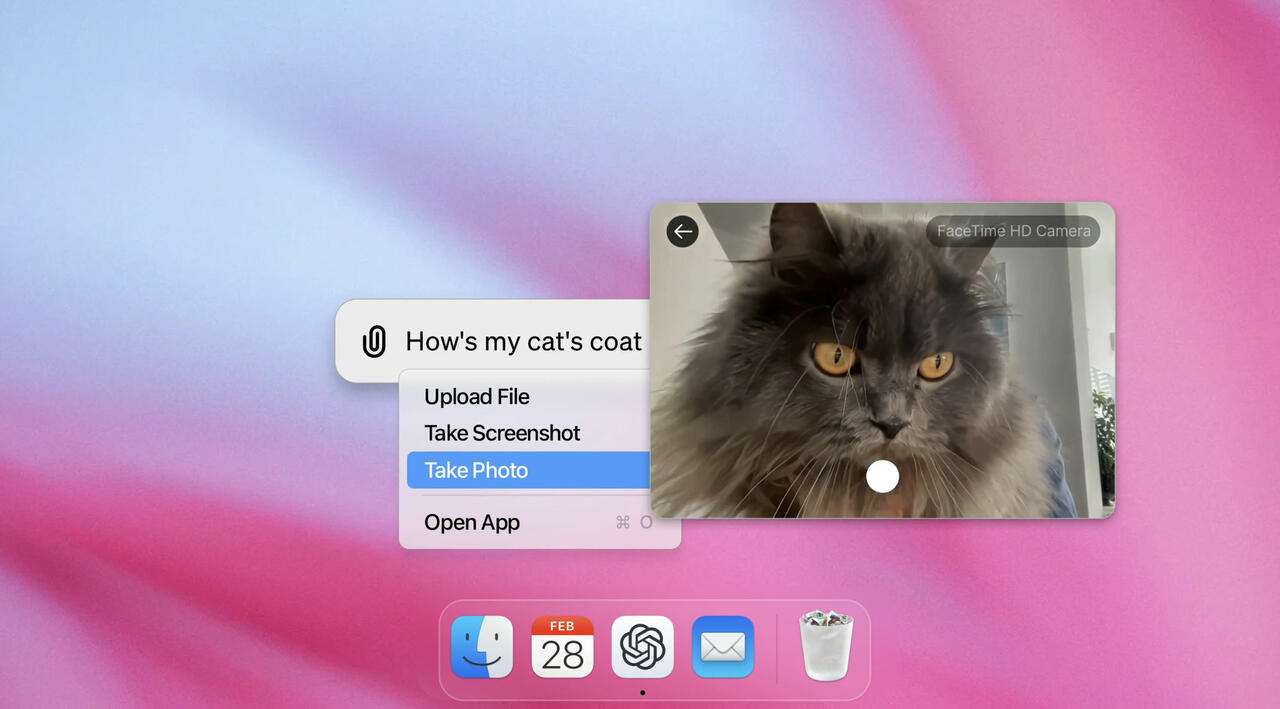

ChatGPT für macOS 1 (Bild © OpenAI)

ChatGPT für macOS 1 (Bild © OpenAI)

ChatGPT hat die Generierung von Inhalten verändert und bietet Nutzern einen neuen Zugang zu Informationen und Daten. Aber auch Missbrauch wird damit betrieben, z. B. durch Schüler, die das Tool zum Schummeln nutzen. Als Reaktion darauf hat OpenAI an einem Erkennungstool gearbeitet, um Nutzer zu identifizieren, die sich bei der Erstellung von Inhalten stark auf ChatGPT verlassen.

Einem Bericht des Wall Street Journal zufolge hat OpenAI seinen Blogbeitrag über das Tool zur Erkennung von KI-generierten Inhalten und die Wasserzeichenmethode aktualisiert. Die Technik ist effektiv, wenn es darum geht, lokale Manipulationen wie Paraphrasen zu erkennen, aber weniger effektiv bei globalen Umschreibungen. Diese Einschränkung könnte ermöglichen, Umgehungslösungen zu finden.

OpenAI bestätigte gegenüber TechCrunch, dass die Genauigkeit der Methode bei fast 99,9 % liegt, aber das Unternehmen vorsichtig bleiben will. Ein Sprecher betonte die Komplexität der Methode und die möglichen Auswirkungen auf das gesamte Ökosystem über OpenAI hinaus.

Eine weitere Sorge ist der mögliche Rückgang der ChatGPT-Nutzung. Ungefähr 30 % der Nutzer gaben an, dass sie das Tool weniger häufig nutzen würden, wenn ein Wasserzeichensystem eingeführt würde. OpenAI erforscht auch Textmetadaten als alternative Erkennungsmethode. Dieser Ansatz, der eine kryptografische Unterschrift beinhaltet, zielt darauf ab, Falschmeldungen zu vermeiden, obwohl seine Effektivität und Auswirkungen noch geprüft werden.

Weitere Artikel zum Thema:

Da OpenAI weiterhin über die beste Vorgehensweise nachdenkt, ist die Veröffentlichung des Erkennungstools noch ungewiss. Wir werden berichten, sobald es hierzu weitere Updates gibt.