AMD Instinct MI300X (Bild © AMD)

AMD Instinct MI300X (Bild © AMD)

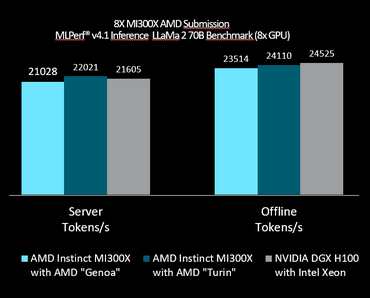

Die AMD Instinct MI300X Grafikprozessoren, die den Open-Source-Software-Stack ROCm verwenden, wurden mit dem LLaMA2-70B-Modell getestet, das ein anerkanntes großes LLM ist und für die Verarbeitung natürlicher Sprache und umfangreiche Inferenzaufgaben entscheidend ist. Mit diesem Benchmark wurden die Fähigkeiten des Grafikprozessors sowohl im Offline- als auch im Serverszenario auf Herz und Nieren geprüft.

Das Offline-Szenario bewertete die Fähigkeit der GPUs, die Stapelverarbeitung von Eingabedaten zu bewältigen, um den Durchsatz zu maximieren, während das Server-Szenario die Echtzeit-Abfrageleistung unter strengen Latenzbedingungen testete. In beiden Fällen zeigte der AMD MI300X, dass er mit den H100-GPUs von NVIDIA mithalten kann und nahezu identische Leistungswerte erreicht.

Fortschrittliche Konfigurationen und effiziente Leistung

In den MLPerf-Beiträgen wurden verschiedene Hardwarekonfigurationen vorgestellt, um die Flexibilität und Stärke des AMD Instinct MI300X zu zeigen. Eine bemerkenswerte Konfiguration umfasste acht MI300X-Grafikprozessoren in Kombination mit AMDs EPYC-CPUs der 4. Generation. Diese Kombination lieferte eine Leistung, die nur 2-3 % unter der von NVIDIAs DGX H100-Systemen mit Intel Xeon-CPUs lag. Diese Konfiguration unterstreicht die Effektivität von AMDs integriertem CPU-GPU-Ansatz für leistungsstarke KI-Workloads.

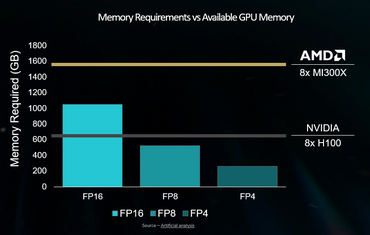

Ein einziger MI300X-Grafikprozessor, der mit gewaltigen 192 GB Speicher ausgestattet ist, konnte das gesamte LLaMA2-70B-Modell ausführen, ohne dass das Modell auf mehrere Grafikprozessoren aufgeteilt werden musste. Diese Fähigkeit reduziert den Netzwerk-Overhead erheblich und maximiert die Effizienz, was sie zu einer attraktiven Option für Rechenzentren macht, die ihre Infrastruktur optimieren wollen.

Robuste Speicher und architektonische Vorteile

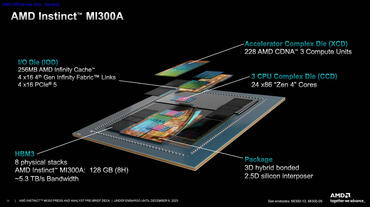

Die AMD Instinct MI300X GPUs basieren auf der CDNA 3-Architektur und verfügen über beeindruckende 192 GB HBM3-Speicher mit einer Bandbreite von bis zu 5,3 TB/s. Dadurch können die Grafikprozessoren selbst die größten Modelle in der KI-Forschung, wie LLaMA2-70B, mühelos verarbeiten. Der MI300X unterstützt außerdem das numerische Format FP8, das sowohl die Leistung als auch die Genauigkeit von KI-Berechnungen erhöht.

AMD wirft einen Blick in die Zukunft

AMD will sich nicht auf seinen Lorbeeren ausrihen. Das Unternehmen plant bereits die nächsten Iterationen der Instinct-Serie und verspricht mehr Speicher, Unterstützung für Datentypen mit geringerer Genauigkeit und eine höhere Rechenleistung. Es wird erwartet, dass die kommenden ROCm Software-Releases weitere Verbesserungen mit sich bringen werden, darunter Kernel-Verbesserungen und fortschrittliche Quantisierungsverfahren.

Da AMD seine KI-Fähigkeiten weiter verfeinert und ausbaut, sind die Instinct MI300X GPUs eine hervorragende Wahl für Unternehmen und Forscher, die leistungsstarke und kostengünstige KI-Lösungen suchen. Bleib dran für zukünftige Benchmarks und Entwicklungen, denn AMD treibt die Entwicklung der KI-Technologie weiter voran.